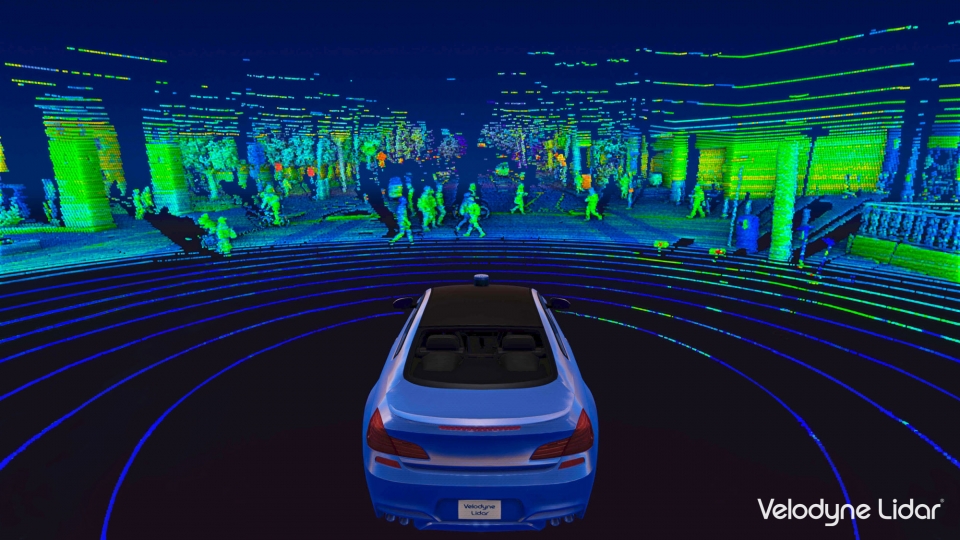

-원문:https://learnopencv.com/3d-lidar-visualization/3D LiDAR센서(또는)의 3차원 빛 감지 및 거리 측정은 우리 인간처럼 3차원 공간에서 실제 세계를 인식할 수 있는 고급 발광 기기입니다.이 기술은 특히 지구 관측, 환경 모니터링, 정찰, 그리고 지금은 자동 운전 분야에 혁명을 가져왔습니다.정확하고 상세한 데이터를 제공하는 능력은 환경과 천연 자원에 대한 이해와 관리를 발전시키는 데 중요한 역할을 했습니다.-원문:https://learnopencv.com/3d-lidar-visualization/3D LiDAR센서(또는)의 3차원 빛 감지 및 거리 측정은 우리 인간처럼 3차원 공간에서 실제 세계를 인식할 수 있는 고급 발광 기기입니다.이 기술은 특히 지구 관측, 환경 모니터링, 정찰, 그리고 지금은 자동 운전 분야에 혁명을 가져왔습니다.정확하고 상세한 데이터를 제공하는 능력은 환경과 천연 자원에 대한 이해와 관리를 발전시키는 데 중요한 역할을 했습니다.

이 결정적인 연구 논문에서 우리는 3D LiDAR센서 데이터를 시각화함 종합적으로 몰리며 자동 운전 자율성을 위한 3D포인트 클라우드 표현 시스템에 대한 심층적 이해를 얻으려고 노력합니다.이 기사의 정점인 3D포인트 클라우드의 시각화를 나타내실험 결과를 기대하세요.결과를 표시하려면 아래로 스크롤 해서 기사의 마지막 부분에 이동하는지 여기를 클릭하고 시각화의 결과를 확인하세요.이 결정적인 연구 논문에서 우리는 3D LiDAR센서 데이터를 시각화함 종합적으로 몰리며 자동 운전 자율성을 위한 3D포인트 클라우드 표현 시스템에 대한 심층적 이해를 얻으려고 노력합니다.이 기사의 정점인 3D포인트 클라우드의 시각화를 나타내실험 결과를 기대하세요.결과를 표시하려면 아래로 스크롤 해서 기사의 마지막 부분에 이동하는지 여기를 클릭하고 시각화의 결과를 확인하세요.

레이저 기술의 진화와 영향 1960년 Hughes Research Laboratory의 Theodore Maiman과 그의 팀은 고출력 플래시 램프에서 루비의 막대기를 비추어 최초의 레이저 빔을 생성하는 것으로 획기적인 발견을 했습니다(Xin Wang et al.[1]).이 코히오렝토한 광 빔은 뛰어난 밝기, 정밀, 간섭 저항성으로 기술에 큰 진전을 이루었습니다.뛰어난 밝기, 지향성, 장해 방지 기능이라는 고유의 특성을 지닌 레이저 기술은 그 후에 거리 측정 분야에서 없어서는 안 되는 기술이 되었습니다.기존의 측정 방법에 비하여 레이저 기반 기술은 높은 정밀도와 분해능을 제공합니다.또 소형의 크기, 사용 편의성, 다양한 조건에서 작동할 수 있는 기능이 특징으로 광범위한 응용 분야에서 매우 귀중합니다.처음에는 레이저 거리 측정이 주로 군사 및 과학 연구 장비에 사용되어 산업용 장비에 적용하는 경우는 비교적 드물어요.이러한 제한된 사용은 주로 레이저 거리 측정 센서의 비용이 많이 들어갔기 때문인데, 일반적으로 수천달러에 달했습니다.이 막대한 비용은 더 광범위한 채택에 대한 상당한 장벽이었습니다.그러나 기술의 상당한 발전으로 시나리오는 극적으로 바뀌었습니다.이런 센서의 비용은 꽤 줄어 현재는 불과 수백달러에 불과합니다.이런 가격 인하는 레이저 거리 측정을 미래의 다양한 장거리 검사 애플리케이션에 대한 실행 가능하고 비용 효율적인 솔루션으로서 자리 매김했습니다.레이저 기술의 진화와 영향 1960년 Hughes Research Laboratory의 Theodore Maiman과 그의 팀은 고출력 플래시 램프에서 루비의 막대기를 비추어 최초의 레이저 빔을 생성하는 것으로 획기적인 발견을 했습니다(Xin Wang et al.[1]).이 코히오렝토한 광 빔은 뛰어난 밝기, 정밀, 간섭 저항성으로 기술에 큰 진전을 이루었습니다.뛰어난 밝기, 지향성, 장해 방지 기능이라는 고유의 특성을 지닌 레이저 기술은 그 후에 거리 측정 분야에서 없어서는 안 되는 기술이 되었습니다.기존의 측정 방법에 비하여 레이저 기반 기술은 높은 정밀도와 분해능을 제공합니다.또 소형의 크기, 사용 편의성, 다양한 조건에서 작동할 수 있는 기능이 특징으로 광범위한 응용 분야에서 매우 귀중합니다.처음에는 레이저 거리 측정이 주로 군사 및 과학 연구 장비에 사용되어 산업용 장비에 적용하는 경우는 비교적 드물어요.이러한 제한된 사용은 주로 레이저 거리 측정 센서의 비용이 많이 들어갔기 때문인데, 일반적으로 수천달러에 달했습니다.이 막대한 비용은 더 광범위한 채택에 대한 상당한 장벽이었습니다.그러나 기술의 상당한 발전으로 시나리오는 극적으로 바뀌었습니다.이런 센서의 비용은 꽤 줄어 현재는 불과 수백달러에 불과합니다.이런 가격 인하는 레이저 거리 측정을 미래의 다양한 장거리 검사 애플리케이션에 대한 실행 가능하고 비용 효율적인 솔루션으로서 자리 매김했습니다.

그림 1 : 레이저 거리 측정 시스템의 유형 그림 1 : 레이저 거리 측정 시스템의 유형

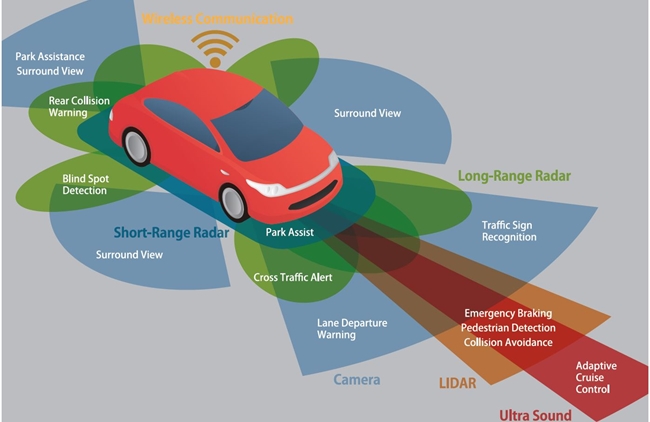

단일 빔, 2차원 및 3차원 시스템을 포함한 여러가지 타입의 레이저 거리 측정 시스템이 개발되었습니다.단일 빔 시스템은 거리 측정 때문에 설계되었으며, 2차원 시스템은 평면 스캐닝으로 설계됐으며 3차원 시스템은 좌표 및 프로파일링을 결정하기 위해서 설계되었습니다.이런 고급 레이저 거리 측정 시스템의 고 정밀, 빠른 속도와 강력한 간섭 방지 기능은 연구 및 응용 분야에서 상당한 관심을 받았습니다.그 결과 전 세계 대학 및 연구소의 많은 연구자들이 이 기술을 탐구하고 개선에 적극 참가하고 있습니다.자율 주행에서 3D LiDAR의 중요한 역할 LiDAR센서는 차량 주변의 정확한 실시간 3D지도를 생성할 능력에 의해서 고급 운전자 지원 시스템에서 자율 구성 요소의 중요성을 높이는 데 중요한 역할을 합니다.다음은 그 중요성을 증명하는 몇가지 구체적인 이유입니다.고해상도 공간 매핑:3D LiDAR센서는 레이저 빔을 방출하고 거리를 측정한 다음 반사된 빛을 사용하고 환경에 대한 자세한 3차원 지도를 만듭니다.이 고해상도의 공간의 매핑은 자율 주행 차가 복잡한 환경을 안전하게 탐색하는데 필수적입니다.범위 및 정밀도:이런 시스템은 매우 정확, 물체와 그 크기를 정확히 감지할 수 있습니다.다양한 거리에서 효과적이어서 자율 주행 차가 가깝고도 먼 물체를 감지할 수 있고, 이는 경로 계획과 장애물 회피로 중요합니다.모든 날씨 성능: 다른 센서와 마찬가지로 3D LiDAR은 극한의 기상 조건에 영향을 받을 수 있습니다.그러나 카메라가 어려움을 겪을 수 있는 저조도 시나리오를 포함한 다양한 환경과 기상 조건에서 안정적으로 작동합니다.물체의 감지 및 분류:물체를 감지하는 것뿐만 아니라 크기, 모양이나 동작에 의해서 분류하는 데도 도움이 됩니다.이는 보행자, 다른 차량 및 정적 장애물 같은 다양한 요소를 자율 주행 차를 구분하는데 중요합니다.실시간 처리나 계산:이런 센서는 실시간으로 데이터를 처리하는 자율 주행 차량 시스템에 즉각적인 피드백을 제공할 수 있습니다.이것은 동적 주행 시나리오에서 신속한 결정을 내리는 데 필수입니다.3D LiDAR데이터 분석으로 3D시각화의 주요 역할 LiDAR데이터 분석은 대단히 중요하며 복잡한 공간 환경을 해석하고 이해하는 방식을 근본적으로 변화시킵니다.이는 다음과 같은 이유로 중요합니다.상세한 환경 표현:3D시각화를 통해서 LiDAR에서 캡처한 환경을 포괄적으로 표현할 수 있습니다.원시 데이터 포인트를 시각적으로 일관하고 해석이 가능한 3차원 모델로 변환하면서 물리적 공간에 대한 명확하고 상세한 예를 제공합니다.향상된 데이터 해석:기존의 2D표현은 지형과 구조물에 대한 중요 세부 정보를 숨기거나 평평하게 만들 수 있습니다.한편 3D시각화는 깊이 인식과 공간 인식을 제공했으며 이는 3D LiDAR센서 데이터를 정확하게 해석하는데 필수적입니다.대화형 분석:3D시각화 도구를 사용하면 종종 사용자가 확대, 이동, 회전과 함께 데이터와 상호 작용할 수 있습니다.이런 상호 작용은 사용자가 다양한 각도와 관점에서 데이터를 탐색할 수 있도록 하고 분석을 향상시킵니다.최첨단 연구:3D LiDAR시각화 기술에 대한 논문이 섹션에서는 3D시각화가 복잡한 데이터를 이해하고 새로운 문제를 해결하는데 도움이 되는 여러가지 실장 및 사용 사례를 살펴보겠습니다.Xiohan Tu et al.[2]는 깊이별 및 점별 상승과 어텐션 모듈에 강화된 가벼운 딥 러닝 모델의 RobotNet을 개발했습니다.이 모델은 고속 철도 검사를 목표로 3D LiDAR센서 데이터에서 오버 헤드 접촉(OC)구성 요소를 효율적이고 정확하게 인식하도록 특별히 설계되었습니다.임베디드 장치에서 속도를 높이기 때문에 RobotNet은 컴파일 도구를 활용하고 더욱 최적화되었습니다.단일 빔, 2차원 및 3차원 시스템을 포함한 여러가지 타입의 레이저 거리 측정 시스템이 개발되었습니다.단일 빔 시스템은 거리 측정 때문에 설계되었으며, 2차원 시스템은 평면 스캐닝으로 설계됐으며 3차원 시스템은 좌표 및 프로파일링을 결정하기 위해서 설계되었습니다.이런 고급 레이저 거리 측정 시스템의 고 정밀, 빠른 속도와 강력한 간섭 방지 기능은 연구 및 응용 분야에서 상당한 관심을 받았습니다.그 결과 전 세계 대학 및 연구소의 많은 연구자들이 이 기술을 탐구하고 개선에 적극 참가하고 있습니다.자율 주행에서 3D LiDAR의 중요한 역할 LiDAR센서는 차량 주변의 정확한 실시간 3D지도를 생성할 능력에 의해서 고급 운전자 지원 시스템에서 자율 구성 요소의 중요성을 높이는 데 중요한 역할을 합니다.다음은 그 중요성을 증명하는 몇가지 구체적인 이유입니다.고해상도 공간 매핑:3D LiDAR센서는 레이저 빔을 방출하고 거리를 측정한 다음 반사된 빛을 사용하고 환경에 대한 자세한 3차원 지도를 만듭니다.이 고해상도의 공간의 매핑은 자율 주행 차가 복잡한 환경을 안전하게 탐색하는데 필수적입니다.범위 및 정밀도:이런 시스템은 매우 정확, 물체와 그 크기를 정확히 감지할 수 있습니다.다양한 거리에서 효과적이어서 자율 주행 차가 가깝고도 먼 물체를 감지할 수 있고, 이는 경로 계획과 장애물 회피로 중요합니다.모든 날씨 성능: 다른 센서와 마찬가지로 3D LiDAR은 극한의 기상 조건에 영향을 받을 수 있습니다.그러나 카메라가 어려움을 겪을 수 있는 저조도 시나리오를 포함한 다양한 환경과 기상 조건에서 안정적으로 작동합니다.물체의 감지 및 분류:물체를 감지하는 것뿐만 아니라 크기, 모양이나 동작에 의해서 분류하는 데도 도움이 됩니다.이는 보행자, 다른 차량 및 정적 장애물 같은 다양한 요소를 자율 주행 차를 구분하는데 중요합니다.실시간 처리나 계산:이런 센서는 실시간으로 데이터를 처리하는 자율 주행 차량 시스템에 즉각적인 피드백을 제공할 수 있습니다.이것은 동적 주행 시나리오에서 신속한 결정을 내리는 데 필수입니다.3D LiDAR데이터 분석으로 3D시각화의 주요 역할 LiDAR데이터 분석은 대단히 중요하며 복잡한 공간 환경을 해석하고 이해하는 방식을 근본적으로 변화시킵니다.이는 다음과 같은 이유로 중요합니다.상세한 환경 표현:3D시각화를 통해서 LiDAR에서 캡처한 환경을 포괄적으로 표현할 수 있습니다.원시 데이터 포인트를 시각적으로 일관하고 해석이 가능한 3차원 모델로 변환하면서 물리적 공간에 대한 명확하고 상세한 예를 제공합니다.향상된 데이터 해석:기존의 2D표현은 지형과 구조물에 대한 중요 세부 정보를 숨기거나 평평하게 만들 수 있습니다.한편 3D시각화는 깊이 인식과 공간 인식을 제공했으며 이는 3D LiDAR센서 데이터를 정확하게 해석하는데 필수적입니다.대화형 분석:3D시각화 도구를 사용하면 종종 사용자가 확대, 이동, 회전과 함께 데이터와 상호 작용할 수 있습니다.이런 상호 작용은 사용자가 다양한 각도와 관점에서 데이터를 탐색할 수 있도록 하고 분석을 향상시킵니다.최첨단 연구:3D LiDAR시각화 기술에 대한 논문이 섹션에서는 3D시각화가 복잡한 데이터를 이해하고 새로운 문제

그림 2: 논문에서 발췌한 사용자 지정 3D 시각화 도구[2] 그림 2: 논문에서 발췌한 사용자 지정 3D 시각화 도구[2]

이를 보완하겠다며 팀은 OC구성 요소의 복잡한 상세 정보를 포함한 광범위한 포인트 클라우드 데이터를 시각화할 수 있는 소프트웨어도 설계했습니다.광범위한 실험을 통해서 RobotNet이 다른 방법보다 정확도와 효율성 면에서 우수한 성능을 보이고 있어 추론 속도가 대폭 증가하고 계산 복잡도가 감소했습니다.Nicholas Crabb등의 논문[3]는 LiDAR를 사용하고 자연 및 고고학적 특징을 매핑으로 해석하는 방법을 탐구하고 특히 지질 고고학적 퇴적물의 모델에 통합하는 데 중점을 둡니다.저자는 LiDAR고도 모델, 특히 고고학적으로 풍부한 하천 환경에 대한 다양한 시각화 방법에 대한 포괄적인 검토와 정량적 평가를 실행합니다.이를 보완하겠다며 팀은 OC구성 요소의 복잡한 상세 정보를 포함한 광범위한 포인트 클라우드 데이터를 시각화할 수 있는 소프트웨어도 설계했습니다.광범위한 실험을 통해서 RobotNet이 다른 방법보다 정확도와 효율성 면에서 우수한 성능을 보이고 있어 추론 속도가 대폭 증가하고 계산 복잡도가 감소했습니다.Nicholas Crabb등의 논문[3]는 LiDAR를 사용하고 자연 및 고고학적 특징을 매핑으로 해석하는 방법을 탐구하고 특히 지질 고고학적 퇴적물의 모델에 통합하는 데 중점을 둡니다.저자는 LiDAR고도 모델, 특히 고고학적으로 풍부한 하천 환경에 대한 다양한 시각화 방법에 대한 포괄적인 검토와 정량적 평가를 실행합니다.

그림 3: 논문 [3]에서 발췌한 지리적 1m LiDAR DTM 시각화 그림 3: 논문 [3]에서 발췌한 지리적 1m LiDAR DTM 시각화

그들은 온대, 저지대의 범람원의 그 부조 특성에 의해서 몇가지 시각화 방법만 고고학적 자원의 분포와 관련된 지형학적 지형의 탐지를 크게 향상시킨다는 것을 발견했습니다.이 연구는 상대 고도 모델과 단순 지역적 원조 모델을 결합하는 것이 가장 효과적인 퇴적물의 모델과 최적의 통합을 제공한다는 결론을 내렸습니다.이 연구는 범람원 환경에 중점을 두고 있지만, 방법론과 결과는 다양한 조형적 맥락에서 광범위에 적용될 수 있습니다.Jyoti Madake et al.[4]는 컴퓨터 비전에서 장애물 탐지 문제를 다루고 있으며 주로 로봇 공학 및 자동화에 사용되는 카메라와 LiDAR데이터를 결합하는 다중 모달리티을 사용한 객체 탐지에 중점을 둡니다.이는 오브젝트 탐지에 필수적인 포인트 클라우드를 만들면서 LiDAR의 효과를 강조하고 이를 위하고 다양한 딥 러닝 모델을 사용합니다.그들은 온대, 저지대의 범람원의 그 부조 특성에 의해서 몇가지 시각화 방법만 고고학적 자원의 분포와 관련된 지형학적 지형의 탐지를 크게 향상시킨다는 것을 발견했습니다.이 연구는 상대 고도 모델과 단순 지역적 원조 모델을 결합하는 것이 가장 효과적인 퇴적물의 모델과 최적의 통합을 제공한다는 결론을 내렸습니다.이 연구는 범람원 환경에 중점을 두고 있지만, 방법론과 결과는 다양한 조형적 맥락에서 광범위에 적용될 수 있습니다.Jyoti Madake et al.[4]는 컴퓨터 비전에서 장애물 탐지 문제를 다루고 있으며 주로 로봇 공학 및 자동화에 사용되는 카메라와 LiDAR데이터를 결합하는 다중 모달리티을 사용한 객체 탐지에 중점을 둡니다.이는 오브젝트 탐지에 필수적인 포인트 클라우드를 만들면서 LiDAR의 효과를 강조하고 이를 위하고 다양한 딥 러닝 모델을 사용합니다.

그림 4: 논문[4]의 예시 포인트 클라우드 시각화 그림 4: 논문[4]의 예시 포인트 클라우드 시각화

저자들은 Open3D라이브러리로 처리한 카메라 및 LiDAR데이터를 사용하는 차량 감지 시스템을 제안했습니다.랜덤 샘플 합의(RANSAC)과 노이즈가 있는 어플리케이션의 밀도 기반 공간 쿠르 로스트 린(DBSCAN) 같은 기술은 LiDAR포인트 클라우드로 시각화 및 쿠르 로스트 린에 적용됩니다.이 연구는 KITTI, Waymo Open Dataset, Lyft Level 5 AV Dataset 같은 주요 데이터 세트를 활용하며 차량을 클러스터에 감지하는 것을 목표로 합니다.Jaya Sreevalsan의[5]연구는 공중 LiDAR데이터 세트의 3D분석에 초점을 맞추고 특히 포인트 클라우드의 처리에서 시각적 분석의 역할을 탐구합니다.그들은 포인트 클라우드의 비지도 분류와 로컬 지오 메트리 분석이라는 두가지 주요 응용 프로그램 시나리오를 탐구합니다.이 연구는 포인트 클라우드의 구조적(점, 선 표면)및 의미적(건물 바닥 식물)의 분류를 논의합니다.도시 지역을 강조하고 이 연구는 이러한 객체 클래스가 널리 퍼지고 있는 데이터 세트를 활용합니다.이 팀은 텐서의 투표나 그래디 언트 에너지 텐서를 사용하여 로컬 기하학적 설명자를 개발하고 기존의 공분산 행렬에 대한 접근법에 대한 대안을 제공합니다.그녀의 작업은 사용자 상호 작용과 시각화를 데이터 과학 워크 플로에 통합하고 대규모 공중 LiDAR포인트 클라우드를 효과적으로 탐색하는 이점을 보이고 줍니다.저자들은 Open3D라이브러리로 처리한 카메라 및 LiDAR데이터를 사용하는 차량 감지 시스템을 제안했습니다.랜덤 샘플 합의(RANSAC)과 노이즈가 있는 어플리케이션의 밀도 기반 공간 쿠르 로스트 린(DBSCAN) 같은 기술은 LiDAR포인트 클라우드로 시각화 및 쿠르 로스트 린에 적용됩니다.이 연구는 KITTI, Waymo Open Dataset, Lyft Level 5 AV Dataset 같은 주요 데이터 세트를 활용하며 차량을 클러스터에 감지하는 것을 목표로 합니다.Jaya Sreevalsan의[5]연구는 공중 LiDAR데이터 세트의 3D분석에 초점을 맞추고 특히 포인트 클라우드의 처리에서 시각적 분석의 역할을 탐구합니다.그들은 포인트 클라우드의 비지도 분류와 로컬 지오 메트리 분석이라는 두가지 주요 응용 프로그램 시나리오를 탐구합니다.이 연구는 포인트 클라우드의 구조적(점, 선 표면)및 의미적(건물 바닥 식물)의 분류를 논의합니다.도시 지역을 강조하고 이 연구는 이러한 객체 클래스가 널리 퍼지고 있는 데이터 세트를 활용합니다.이 팀은 텐서의 투표나 그래디 언트 에너지 텐서를 사용하여 로컬 기하학적 설명자를 개발하고 기존의 공분산 행렬에 대한 접근법에 대한 대안을 제공합니다.그녀의 작업은 사용자 상호 작용과 시각화를 데이터 과학 워크 플로에 통합하고 대규모 공중 LiDAR포인트 클라우드를 효과적으로 탐색하는 이점을 보이고 줍니다.

그림 5: 논문[5]에서 발췌한 Vaihingen 벤치마크 데이터 세트의 포인트 렌더링 그림 5: 논문[5]에서 발췌한 Vaihingen 벤치마크 데이터 세트의 포인트 렌더링

방법론 Velodyne HDL-64ES23D LiDAR 센서 HDL-64E의 최신 S2 버전은 이전 버전에 비해 정확도가 향상되고 데이터 전송 속도가 더욱 빨라지며 제품 라인에서 주목할 만한 진화를 이루었습니다. 방법론 Velodyne HDL-64ES23D LiDAR 센서 HDL-64E의 최신 S2 버전은 이전 버전에 비해 정확도가 향상되고 데이터 전송 속도가 더욱 빨라지며 제품 라인에서 주목할 만한 진화를 이루었습니다.

그림 6 : Velodyne HDL-64E 3D LiDAR 센서 그림 6 : Velodyne HDL-64E 3D LiDAR 센서

하이라이트 Velodyne HDL-64E S2는 포괄적인 360도 수평 및 26.8도 수직 시야를 제공하고 매초 130만 포인트 이상의 광범위한 환경 데이터 캡처를 제공합니다.혁신적인 디자인은 단일 회전 장치에 64개의 고정 장착 레이저가 포함되고 있으며 기존의 LiDAR시스템에 비해서 안정성과 포인트 클라우드 밀도가 향상되었습니다.고 성능 사양을 갖춘 HDL-64E S2는 다양한 환경 조건에 이상적인 뛰어난 거리 정확도와 효과적인 감지 범위를 제공합니다.DARPA Grand및 Urban Challenges 같은 권위 있는 이벤트로 입증된 이 센서의 실적은 실제의 자율 주행 자동차 애플리케이션에 대한 유효성과 안정성을 강조합니다.HDL-64E S2에는 64개의 레이저/감지기가 있어 360번 방위각 시야와 0.08번 각 분해능을 제공합니다.수직 시야는 26.8도였고, 64개의 등간격 각도 세분화가 있습니다.이 센서는 2cm미만 거리 정확도와 최대 120m의 범위를 자랑하고 자동차와 나뭇잎을 감지하고 다양한 환경에서 매우 효과적입니다.이 센서는-10°~50°C의 온도 범위에서 효율적으로 작동하고-10°~80°C의 보관 온도 범위를 가집니다.사용자의 편의성을 염두에 두고 설계된 HDL-64E S2는 905nm파장의 클래스 1안전째 레이저를 사용합니다.확장된 동적 범위를 위한 동적 레이저 전력 선택 기능이 있고 100MBPS UDP이더넷 패킷을 통해서 출력을 제공합니다.이 센서의 기계적 측면에는 4앙페아으로 15V±1.5V의 전력 요구 사항, 29파운드 미만의 무게, IP67등급의 환경 보호가 포함됩니다.2D KITTI 깊은 프레임 데이터 세트 설명 KITTI데이터 세트는 자율 주행 차 연구 분야에서 핵심 자원이 눈에 띕니다.여기에는 다양한 거리 환경이나 시나리오를 통과하는 차량에 장착된 카메라, LiDAR및 기타 센서에서 수집한 포괄적인 데이터 컬렉션이 포함됩니다.이 풍부한 컴파일은 자율 주행 기술을 개발하고 테스트하는 데 필수적인 광범위한 실제 세계 상황을 제공합니다.이전 섹션에 표시된 Velodyne LiDAR센서는 이 특정 데이터 세트의 데이터를 수집하는데 사용되었습니다.하이라이트 복잡한 LiDAR데이터 변환:KITTI LiDAR기반 2D 깊은 이미지 데이터 세트는 360번 LiDAR프레임을 2D형식에서 고유하게 변환하는 기능을 제공합니다.이 프로세스는 원통 LiDAR프레임을 ‘온 레 핀’ 하고 복잡한 3차원 데이터를 2차원에서 더 쉽게 접근으로 처리할 수 있도록 하는 것이 포함됩니다.픽셀 단위의 깊이 정보:이 데이터 세트로 2D 깊은 이미지의 각 픽셀은 3D LiDAR센서에서 환경의 객체까지의 거리를 나타냅니다.이 접근 방식은 원래 LiDAR데이터의 완전성을 유지하고 동일한 장면을 더 처리하기 쉬운 형식으로 효과적으로 캡처합니다.세부 스캐닝을 위한 비싼 수직 해상도:이 데이터 세트는 3D LiDAR센서로 사용하는 레이저 빔의 수를 반영하고 64의 높은 수직 해상도를 설정합니다.이 높은 해상도는 정밀한 환경 모델링에 필수적인 주변 환경의 세부적인 스캐닝 및 매핑을 보장합니다.하이라이트 Velodyne HDL-64E S2는 포괄적인 360도 수평 및 26.8도 수직 시야를 제공하고 매초 130만 포인트 이상의 광범위한 환경 데이터 캡처를 제공합니다.혁신적인 디자인은 단일 회전 장치에 64개의 고정 장착 레이저가 포함되고 있으며 기존의 LiDAR시스템에 비해서 안정성과 포인트 클라우드 밀도가 향상되었습니다.고 성능 사양을 갖춘 HDL-64E S2는 다양한 환경 조건에 이상적인 뛰어난 거리 정확도와 효과적인 감지 범위를 제공합니다.DARPA Grand및 Urban Challenges 같은 권위 있는 이벤트로 입증된 이 센서의 실적은 실제의 자율 주행 자동차 애플리케이션에 대한 유효성과 안정성을 강조합니다.HDL-64E S2에는 64개의 레이저/감지기가 있어 360번 방위각 시야와 0.08번 각 분해능을 제공합니다.수직 시야는 26.8도였고, 64개의 등간격 각도 세분화가 있습니다.이 센서는 2cm미만 거리 정확도와 최대 120m의 범위를 자랑하고 자동차와 나뭇잎을 감지하고 다양한 환경에서 매우 효과적입니다.이 센서는-10°~50°C의 온도 범위에서 효율적으로 작동하고-10°~80°C의 보관 온도 범위를 가집니다.사용자의 편의성을 염두에 두고 설계된 HDL-64E S2는 905nm파장의 클래스 1안전째 레이저를 사용합니다.확장된 동적 범위를 위한 동적 레이저 전력 선택 기능이 있고 100MBPS UDP이더넷 패킷을 통해서 출력을 제공합니다.이 센서의 기계적 측면에는 4앙페아으로 15V±1.5V의 전력 요구 사항, 29파운드 미만의 무게, IP67등급의 환경 보호가 포함됩니다.2D KITTI 깊은 프레임 데이터 세트 설명 KITTI데이터 세트는 자율 주행 차 연구 분야에서 핵심 자원이 눈에 띕니다.여기에는 다양한 거리 환경이나 시나리오를 통과하는 차량에 장착된 카메라, LiDAR및 기타 센서에서 수집한 포괄적인 데이터 컬렉션이 포함됩니다.이 풍부한 컴파일은 자율 주행 기술을 개발하고 테스트하는 데 필수적인 광범위한 실제 세계 상황을 제공합니다.이전 섹션에 표시된 Velodyne LiDAR센서는 이 특정 데이터 세트의 데이터를 수집하는데 사용되었습니다.하이라이트 복잡한 LiDAR데이터 변환:KITTI LiDAR기반 2D 깊은 이미지 데이터 세트는 360번 LiDAR프레임을 2D형식에서 고유하게 변환하는 기능을 제공합니다.이 프로세스는 원통 LiDAR프레임을 ‘온 레 핀’ 하고 복잡한 3차원 데이터를 2차원에서 더 쉽게 접근으로 처리할 수 있도록 하는 것이 포함됩니다.픽셀 단위의 깊이 정보:이 데이터 세트로 2D 깊은 이미지의 각 픽셀은 3D LiDAR센서에서 환경의 객체까지의 거리를 나타냅니다.이 접근 방식은 원래 LiDAR데이터의 완전성을 유지하고 동일한 장면을 더 처리하기 쉬운 형식으로 효과적으로 캡처합니다.세부 스캐닝을 위한 비싼 수직 해상도:이 데이터 세트는 3D LiDAR센서로 사용하는 레이저 빔의 수를 반영하고 64의 높은 수직 해상도를 설정합니다.이 높은 해상도는 정밀한 환경 모델링에 필수적인 주변 환경의 세부적인 스캐닝 및 매핑을 보장합니다.

그림 7 : Velodyne LiDAR 센서를 사용한 KITTI 데이터 세트의 2D 깊이 프레임 그림 7 : Velodyne LiDAR 센서를 사용한 KITTI 데이터 세트의 2D 깊이 프레임

이 특정 하위 세트에서는 KITTI데이터 세트의 LiDAR프레임에서 파생된 2D 깊은 이미지에 초점을 맞춥니다.이런 이미지는 일반적으로 센서의 주변에 원통형 형태로 표시되는 원래 360번 LiDAR프레임 변환을 나타냅니다.변환 프로세스는 기본적으로 원통형 LiDAR프레임을 2D평면에 ‘창조’것도 포함하여 이를 통해서 복잡한 3차원 데이터를 보다 접근하기 쉬운 2차원 형식으로 변환합니다.이런 2D 깊은 이미지의 각 픽셀은 LiDAR센서와 레이저 빔에 반사된 물체 사이의 거리에 해당되는 원래 LiDAR프레임과 동일한 장면을 효과적으로 캡처하지만 처리하기 더 간단한 형식에서 캡처합니다.이 데이터 세트에서 64로 설정된 이런 이미지의 수직 해상도는 LiDAR센서가 주변을 스캔 하기 위해서 사용하는 레이저 빔의 수를 나타냅니다.이런 2D 깊은 이미지의 유용성은 분할, 감지 및 인식 작업을 포함한 다양한 애플리케이션에 확장됩니다.LiDAR기술의 고급 기능과 2D이미지 분석에 초점을 맞춘 광범위한 기존 컴퓨터 비전 문헌 간의 가교 역할을 합니다.이를 통해서 KITTI LiDAR기반 2D 깊은 이미지 데이터 세트는 자율 주행 차 연구에 귀중한 자산일 뿐 아니라 광범위한 컴퓨터 비전 과제와 기회를 탐색하는 것에 다재 다능한 도구가 됩니다.Open3D시각화 툴 강조 사항 다재 다능하고 효율적인 3D데이터 처리:Open3D는 3D데이터 처리를 위한 강력한 솔루션을 제공하는 포괄적인 오픈 소스 라이브러리입니다.효율적인 병렬화를 위한 최적화된 백 엔드 아키텍처를 갖추고 있어 복잡한 3D형상과 알고리즘을 처리하는데 이상적입니다.사실적인 3D형태의 모델링 및 분석:이 라이브러리는 정확한 3D모델을 만드는 데 기본으로 하는 장면에 다시 구성 및 표면 정렬을 위한 특수 도구를 제공합니다.물리 기반 레이아웃(PBR)을 구현하고 이런 3D형태의 시각화가 정확하고 있을 뿐 아니라 매우 사실적으로 사용자의 경험과 다양한 전문 시나리오에서 도구의 적용성이 크게 향상됩니다.크로스 플랫폼 호환성:GCC 5.X, XCode 10+, Visual Studio 2019와 같은 다양한 컴파일러를 지원하고 Linux, OS X, Windows에서 원활한 작동을 보장합니다.conda와 pip을 통한 간단한 설치 프로세스를 제공하고 사용자가 빠르고 시간이 걸리지 않도록 설정할 수 있습니다.이 특정 하위 세트에서는 KITTI데이터 세트의 LiDAR프레임에서 파생된 2D 깊은 이미지에 초점을 맞춥니다.이런 이미지는 일반적으로 센서의 주변에 원통형 형태로 표시되는 원래 360번 LiDAR프레임 변환을 나타냅니다.변환 프로세스는 기본적으로 원통형 LiDAR프레임을 2D평면에 ‘창조’것도 포함하여 이를 통해서 복잡한 3차원 데이터를 보다 접근하기 쉬운 2차원 형식으로 변환합니다.이런 2D 깊은 이미지의 각 픽셀은 LiDAR센서와 레이저 빔에 반사된 물체 사이의 거리에 해당되는 원래 LiDAR프레임과 동일한 장면을 효과적으로 캡처하지만 처리하기 더 간단한 형식에서 캡처합니다.이 데이터 세트에서 64로 설정된 이런 이미지의 수직 해상도는 LiDAR센서가 주변을 스캔 하기 위해서 사용하는 레이저 빔의 수를 나타냅니다.이런 2D 깊은 이미지의 유용성은 분할, 감지 및 인식 작업을 포함한 다양한 애플리케이션에 확장됩니다.LiDAR기술의 고급 기능과 2D이미지 분석에 초점을 맞춘 광범위한 기존 컴퓨터 비전 문헌 간의 가교 역할을 합니다.이를 통해서 KITTI LiDAR기반 2D 깊은 이미지 데이터 세트는 자율 주행 차 연구에 귀중한 자산일 뿐 아니라 광범위한 컴퓨터 비전 과제와 기회를 탐색하는 것에 다재 다능한 도구가 됩니다.Open3D시각화 툴 강조 사항 다재 다능하고 효율적인 3D데이터 처리:Open3D는 3D데이터 처리를 위한 강력한 솔루션을 제공하는 포괄적인 오픈 소스 라이브러리입니다.효율적인 병렬화를 위한 최적화된 백 엔드 아키텍처를 갖추고 있어 복잡한 3D형상과 알고리즘을 처리하는데 이상적입니다.사실적인 3D형태의 모델링 및 분석:이 라이브러리는 정확한 3D모델을 만드는 데 기본으로 하는 장면에 다시 구성 및 표면 정렬을 위한 특수 도구를 제공합니다.물리 기반 레이아웃(PBR)을 구현하고 이런 3D형태의 시각화가 정확하고 있을 뿐 아니라 매우 사실적으로 사용자의 경험과 다양한 전문 시나리오에서 도구의 적용성이 크게 향상됩니다.크로스 플랫폼 호환성:GCC 5.X, XCode 10+, Visual Studio 2019와 같은 다양한 컴파일러를 지원하고 Linux, OS X, Windows에서 원활한 작동을 보장합니다.conda와 pip을 통한 간단한 설치 프로세스를 제공하고 사용자가 빠르고 시간이 걸리지 않도록 설정할 수 있습니다.

처음부터 개발된 Open3D은 종속성에 대한 간결하고 목적 지향적인 선택에 초점을 맞추고 3D데이터 처리에서 가볍지만 강력한 도구로 되었습니다.플랫폼 간의 호환성은 핵심 기능과 최소한의 노력으로 다양한 운영 체제에서 간단한 설정과 컴파일이 가능합니다.코드 베이스는 깔끔함, 일관된 스타일, 투명한 코드 검토 프로세스가 특징인 고품질 소프트웨어 엔지니어링 관행에 대한 의지를 반영합니다.Open3D는 시각화의 사실성과 PBR(Physically Based Rendering)을 통합하고 3D형태 시각화에 새로운 수준의 사실성을 제공합니다.포괄적인 3D시각화 기능을 통해서 3D데이터를 대화형으로 탐색하고 사용자 참여와 이해를 향상시킵니다.또 Python바인딩이 포함됐으며 스크립팅과 신속한 프로토 타입 제작을 위한 사용자 친화적이고 강력한 인터페이스를 제공하므로, 이 분야의 초보자와 숙련된 실무자들 모두에게 이상적인 선택입니다.라이브러리의 유용성과 효과는 수많은 출판된 연구 프로젝트에서 사용과 클라우드 기반의 애플리케이션에서의 활발한 배포를 통해서 입증되었습니다.Open3D는 글로벌 오픈 소스 커뮤니티의 공헌을 장려하고 환영하면서 협력적이고 혁신적인 개발 환경을 조성합니다.이를 통해서 Open3D는 3D데이터 처리를 위한 도구일 뿐 아니라 3D데이터 분석이나 시각화 분야에서 협력적 혁신을 위한 플랫폼이 됩니다.3D포인트 클라우드 시각화 코드 웍스의 루이 섹션에서는 KITTI 3D LiDAR센서 스캔 데이터 세트를 시각화하는 것과 관련된 다양한 프로세스를 보고 동일한 데이터 세트의 3D포인트 클라우드 표현을 생성합니다.이 문서의 코드는 코드 다운로드 단추를 클릭하고 다운로드할 수 있습니다.처음부터 개발된 Open3D은 종속성에 대한 간결하고 목적 지향적인 선택에 초점을 맞추고 3D데이터 처리에서 가볍지만 강력한 도구로 되었습니다.플랫폼 간의 호환성은 핵심 기능과 최소한의 노력으로 다양한 운영 체제에서 간단한 설정과 컴파일이 가능합니다.코드 베이스는 깔끔함, 일관된 스타일, 투명한 코드 검토 프로세스가 특징인 고품질 소프트웨어 엔지니어링 관행에 대한 의지를 반영합니다.Open3D는 시각화의 사실성과 PBR(Physically Based Rendering)을 통합하고 3D형태 시각화에 새로운 수준의 사실성을 제공합니다.포괄적인 3D시각화 기능을 통해서 3D데이터를 대화형으로 탐색하고 사용자 참여와 이해를 향상시킵니다.또 Python바인딩이 포함됐으며 스크립팅과 신속한 프로토 타입 제작을 위한 사용자 친화적이고 강력한 인터페이스를 제공하므로, 이 분야의 초보자와 숙련된 실무자들 모두에게 이상적인 선택입니다.라이브러리의 유용성과 효과는 수많은 출판된 연구 프로젝트에서 사용과 클라우드 기반의 애플리케이션에서의 활발한 배포를 통해서 입증되었습니다.Open3D는 글로벌 오픈 소스 커뮤니티의 공헌을 장려하고 환영하면서 협력적이고 혁신적인 개발 환경을 조성합니다.이를 통해서 Open3D는 3D데이터 처리를 위한 도구일 뿐 아니라 3D데이터 분석이나 시각화 분야에서 협력적 혁신을 위한 플랫폼이 됩니다.3D포인트 클라우드 시각화 코드 웍스의 루이 섹션에서는 KITTI 3D LiDAR센서 스캔 데이터 세트를 시각화하는 것과 관련된 다양한 프로세스를 보고 동일한 데이터 세트의 3D포인트 클라우드 표현을 생성합니다.이 문서의 코드는 코드 다운로드 단추를 클릭하고 다운로드할 수 있습니다.

코드 다운로드가 튜토리얼을 쉽게 따르려면 아래 버튼을 클릭하여 코드를 다운로드하십시오. 그것은 무료입니다! 원문에서 다운받으세요. Download Code 코드의 다운로드가 튜토리얼을 쉽게 따르려면 아래 버튼을 클릭하여 코드를 다운로드하세요. 그것은 무료입니다! 원문에서 다운받으세요. Download Code

2D 깊이 화상의 로드 및 읽기 이 코드의 단편은, 2D 깊이 화상을 읽어 처리하도록 작성된 함수 「load_depth_image」를 정의합니다. 2D 깊이 화상의 로드 및 읽기 이 코드의 단편은, 2D 깊이 화상을 읽어 처리하도록 작성된 함수 「load_depth_image」를 정의합니다.

# Read the 2D Depth Imagedef load_depth_image(file_path): # Load the depth image depth_image = plt.imread(file_path) depth_image_scaling_factor = 250.0 # Assuming the depth image is normalized, we may need to scale it to the actual distance values # This scaling factor is dataset-specific; you’ll need to adjust it based on the KITTI dataset documentation depth_image *= depth_image_scaling_factor return depth_image # Read the 2D Depth Imagedef load_depth_image(file_path): # Load the depth image depth_image = plt.imread(file_path) depth_image_scaling_factor = 250.0 # Assuming the depth image is normalized, we may need to scale it to the actual distance values # This scaling factor is dataset-specific; you’ll need to adjust it based on the KITTI dataset documentation depth_image *= depth_image_scaling_factor return depth_image

실행 시 이 함수는 다음 작업을 수행합니다.이미지 삽입:`matplotlib`라이브러리 함수인`plt.imread`을 활용하여 지정된`file_path`에 있는 이미지를 로드합니다.이 단계에서는 이미지 데이터를 읽고`depth_image`변수에 저장합니다.깊은 이미지 스케일링:이 코드는`depth_image_scaling_factor`을 설정합니다.이 스케일링 계수는 이미지의 정규화된 깊이 값을 실제 거리 측정치로 변환하는데 필수적이며, 이는 3D LiDAR센서로 장면의 객체까지 실제 거리를 나타냅니다.스케일링 계수의 값은 데이터 세트마다 다르며 이 경우 KITTI데이터 세트의 특성에 맞게 조정된 것으로 추정됩니다.정규화 조정:이 조정은 정규화된 값을 실제 거리의 보다 의미 있는 표현으로 변환하고 추가 처리 및 분석을 위한 데이터의 유용성을 향상시킵니다.2D심도 프레임의 다양한 후레ー무쵸리이코ー도의 조각은 지정된 디렉토리에서 일련의 2D심도 이미지 파일을 처리하고 포인트 클라우드 데이터로 변환하도록 설계된`load_and_process_frames`함수를 정의합니다.실행 시 이 함수는 다음 작업을 수행합니다.이미지 삽입:`matplotlib`라이브러리 함수인`plt.imread`을 활용하여 지정된`file_path`에 있는 이미지를 로드합니다.이 단계에서는 이미지 데이터를 읽고`depth_image`변수에 저장합니다.깊은 이미지 스케일링:이 코드는`depth_image_scaling_factor`을 설정합니다.이 스케일링 계수는 이미지의 정규화된 깊이 값을 실제 거리 측정치로 변환하는데 필수적이며, 이는 3D LiDAR센서로 장면의 객체까지 실제 거리를 나타냅니다.스케일링 계수의 값은 데이터 세트마다 다르며 이 경우 KITTI데이터 세트의 특성에 맞게 조정된 것으로 추정됩니다.정규화 조정:이 조정은 정규화된 값을 실제 거리의 보다 의미 있는 표현으로 변환하고 추가 처리 및 분석을 위한 데이터의 유용성을 향상시킵니다.2D심도 프레임의 다양한 후레ー무쵸리이코ー도의 조각은 지정된 디렉토리에서 일련의 2D심도 이미지 파일을 처리하고 포인트 클라우드 데이터로 변환하도록 설계된`load_and_process_frames`함수를 정의합니다.

def load_and_process_frames(directory): point_clouds = []for filename in sorted(os.listdir(directory)):if filename.endswith(‘.png’): # Check for PNG images file_path = os.path.join(directory, filename) depth_image = load_depth_image(file_path) point_cloud = depth_image_to_point_cloud(depth_image) point_clouds.append(point_cloud)return point_clouds def load_and_process_frames(directory): point_clouds = []for filename in sorted(os.listdir(directory)):if filename.endswith(‘.png’): # Check for PNG images file_path = os.path.join(directory, filename) depth_image = load_depth_image(file_path) point_cloud = depth_image_to_point_cloud(depth_image) point_clouds.append(point_cloud)return point_clouds

이 함수는 여러 깊은 이미지를 처리하고 분석해야 하는 상황에서 특히 유용합니다.다음은 기능에 대한 상세 정보입니다.포인트 클라우드 리스트 초기화:이 함수는 깊은 이미지 파일이 들어 있는 폴더의 경로를 지정하는 하나의 인수인`directory`를 사용합니다.`point_clouds이라는 리스트는 각 깊은 이미지로 변환된 포인트의 클라우드 데이터를 보존하도록 초기화됩니다.디렉토리 파일 반복:`sorted(os.listdir(directory)`는 파일이 알파벳 순(또는 슷쟈승)으로 처리되도록 보장하는데, 이는 비디오나 3D LiDAR스캔의 프레임과 같은 차례차례 데이터에 특히 중요합니다.파일 유형 검사:루프 내에서 이 함수는 현재 파일이 PNG이미지(`filename.endswith(‘. png’)`)인지 확인합니다.이는 깊은 이미지 파일만 처리되도록 하는 데 중요합니다.깊은 이미지 처리:각 PNG이미지 파일에 대해서, 이 함수는 전체 경로(`file_path`)을 구성한 다음 이전에 정의된 함수`load_depth_image`을 사용하고 깊은 이미지를 로드합니다.이 함수는 깊은 이미지를 읽고 초기 처리를 실시한다고 예상됩니다.포인트 클라우드 변환:로드된 깊이의 이미지는`depth_image_to_point_cloud라는 다른 함수를 사용하고 포인트 클라우드에 변환됩니다.이 함수는 2D이미지로 깊이의 정보를 취득하고, 3D포인트 클라우드 표현으로 변환하고, 각 이미지의 결과 득점 클라우드를`point_clouds`리스트에 추가합니다.디렉토리의 모든 PNG이미지가 처리된 후 이 함수는 포인트 클라우드의 목록을 반환합니다.2D 깊은 프레임을 3D LiDAR포인트 클라우드에 변환`depth_image_to_point_cloud`함수는 2D 깊은 이미지를 3D포인트 클라우드로 변환하도록 설계되었습니다.이 함수는 여러 깊은 이미지를 처리하고 분석해야 하는 상황에서 특히 유용합니다.다음은 기능에 대한 상세 정보입니다.포인트 클라우드 리스트 초기화:이 함수는 깊은 이미지 파일이 들어 있는 폴더의 경로를 지정하는 하나의 인수인`directory`를 사용합니다.`point_clouds이라는 리스트는 각 깊은 이미지로 변환된 포인트의 클라우드 데이터를 보존하도록 초기화됩니다.디렉토리 파일 반복:`sorted(os.listdir(directory)`는 파일이 알파벳 순(또는 슷쟈승)으로 처리되도록 보장하는데, 이는 비디오나 3D LiDAR스캔의 프레임과 같은 차례차례 데이터에 특히 중요합니다.파일 유형 검사:루프 내에서 이 함수는 현재 파일이 PNG이미지(`filename.endswith(‘. png’)`)인지 확인합니다.이는 깊은 이미지 파일만 처리되도록 하는 데 중요합니다.깊은 이미지 처리:각 PNG이미지 파일에 대해서, 이 함수는 전체 경로(`file_path`)을 구성한 다음 이전에 정의된 함수`load_depth_image`을 사용하고 깊은 이미지를 로드합니다.이 함수는 깊은 이미지를 읽고 초기 처리를 실시한다고 예상됩니다.포인트 클라우드 변환:로드된 깊이의 이미지는`depth_image_to_point_cloud라는 다른 함수를 사용하고 포인트 클라우드에 변환됩니다.이 함수는 2D이미지로 깊이의 정보를 취득하고, 3D포인트 클라우드 표현으로 변환하고, 각 이미지의 결과 득점 클라우드를`point_clouds`리스트에 추가합니다.디렉토리의 모든 PNG이미지가 처리된 후 이 함수는 포인트 클라우드의 목록을 반환합니다.2D 깊은 프레임을 3D LiDAR포인트 클라우드에 변환`depth_image_to_point_cloud`함수는 2D 깊은 이미지를 3D포인트 클라우드로 변환하도록 설계되었습니다.

def depth_image_to_point_cloud(depth_image, h_fov=(-90, 90), v_fov=(-24.9, 2.0), d_range=(0,100)): # Adjusting angles for broadcasting h_angles = np.deg2rad(np.linspace(h_fov[0], h_fov[1], depth_image.shape[1])) v_angles = np.deg2rad(np.linspace(v_fov[0], v_fov[1], depth_image.shape[0])) # Reshaping angles for broadcasting h_angles = h_angles[np.newaxis, :] # Shape becomes (1, 1440) v_angles = v_angles[:, np.newaxis] # Shape becomes (64, 1) # Calculate x, y, and z x = depth_image * np.sin(h_angles) * np.cos(v_angles) y = depth_image * np.cos(h_angles) * np.cos(v_angles) z = depth_image * np.sin(v_angles) # Filter out points beyond the distance range valid_indices = (depth_image >= d_range[0]) & (depth_image <= d_range[1]) # Apply the mask to each coordinate array x = x[valid_indices] y = y[valid_indices] z = z[valid_indices] # Stack to get the point cloud point_cloud = np.stack((x, y, z), axis=-1)return point_cloud def depth_image_to_point_cloud(depth_image, h_fov=(-90, 90), v_fov=(-24.9, 2.0), d_range=(0,100)): # Adjusting angles for broadcasting h_angles = np.deg2rad(np.linspace(h_fov[0], h_fov[1], depth_image.shape[1])) v_angles = np.deg2rad(np.linspace(v_fov[0], v_fov[1], depth_image.shape[0])) # Reshaping angles for broadcasting h_angles = h_angles[np.newaxis, :] # Shape becomes (1, 1440) v_angles = v_angles[:, np.newaxis] # Shape becomes (64, 1) # Calculate x, y, and z x = depth_image * np.sin(h_angles) * np.cos(v_angles) y = depth_image * np.cos(h_angles) * np.cos(v_angles) z = depth_image * np.sin(v_angles) # Filter out points beyond the distance range valid_indices = (depth_image >= d_range[0]) & (depth_image <= d_range[1]) # Apply the mask to each coordinate array x = x[valid_indices] y = y[valid_indices] z = z[valid_indices] # Stack to get the point cloud point_cloud = np.stack((x, y, z), axis=-1)return point_cloud

이 변환은 특히 LiDAR데이터 처리 맥락에서 유용합니다.여기서 2D이미지의 깊이 정보가 공간적으로 유익한 3D형식으로 변환됩니다.이 함수의 작업은 다음과 같습니다.브로드캐스팅을 위한 각도 조정:이 함수는 4개의 매개 변수를 허용합니다.입력 2D의 깊이의 이미지인`depth_image`, 각각 수평 및 수직 시야(FoV)을 나타내는`h_fov`나`v_fov`, 깊이 데이터를 필터링 하기 위한 거리 범위를 지정하는`d_range)입니다.제공된 시야를 기반으로 하는 수평(`h_angles`)및 수직(`v_angles`)각도입니다.`np.linspace`을 사용하여 지정된 FoV의 범위 내에서 균일하게 간격이 있는 각도를 만든 뒤`np.deg2rad`를 사용하고 이런 각도를 길에서 라디안으로 변환합니다.각도 재형성:수평 각도는(1, 깊이의 이미지의 열 수)형태로 재형성되어 수직 각도는(더 깊은 이미지의 행 수, 1)에서 재형성됩니다.이 재형성은 깊은 이미지로 요소별 연산을 수행할 때 방송을 쉽게 합니다.3D좌표 계산:포인트 클라우드의 각 포인트 x, y, z좌표는 삼각 연산을 사용하여 계산됩니다.깊은 이미지의 깊이 값은 계산된 각도의 사인과 코사인과 함께 사용되고 3D공간에서 각 포인트의 위치를 결정합니다. 거리 범위 필터링:지정된 대로 범위(`d_range`)에 속하지 않는 포인트는 필터링 됩니다.이는 깊이 값을 기반으로 마스크를 생성하고, 각 좌표 배열(x, y, z)에 적용하고 달성됩니다.3D포인트 클라우드 구성:유효한 x, y, z좌표는 새로운 축을 읽고 쌓아 최종 3D점 클라우드를 형성합니다.그 결과 각 요소가 3D공간의 포인트를 나타내는 배열이 생성됩니다.마지막으로 계산된 포인트의 클라우드는 이제 3차원 시각화 및 분석에 적합한 형식으로 되었습니다.포인트 클라우드 표현 시뮬레이션`animate_point_clouds`함수는 Open3D라이브러리를 사용하고 3D포인트 클라우드 시퀀스를 애니메이션화하도록 설계된 Python작업입니다.이 변환은 특히 LiDAR데이터 처리 맥락에서 유용합니다.여기서 2D이미지의 깊이 정보가 공간적으로 유익한 3D형식으로 변환됩니다.이 함수의 작업은 다음과 같습니다.브로드캐스팅을 위한 각도 조정:이 함수는 4개의 매개 변수를 허용합니다.입력 2D의 깊이의 이미지인`depth_image`, 각각 수평 및 수직 시야(FoV)을 나타내는`h_fov`나`v_fov`, 깊이 데이터를 필터링 하기 위한 거리 범위를 지정하는`d_range)입니다.제공된 시야를 기반으로 하는 수평(`h_angles`)및 수직(`v_angles`)각도입니다.`np.linspace`을 사용하여 지정된 FoV의 범위 내에서 균일하게 간격이 있는 각도를 만든 뒤`np.deg2rad`를 사용하고 이런 각도를 길에서 라디안으로 변환합니다.각도 재형성:수평 각도는(1, 깊이의 이미지의 열 수)형태로 재형성되어 수직 각도는(더 깊은 이미지의 행 수, 1)에서 재형성됩니다.이 재형성은 깊은 이미지로 요소별 연산을 수행할 때 방송을 쉽게 합니다.3D좌표 계산:포인트 클라우드의 각 포인트 x, y, z좌표는 삼각 연산을 사용하여 계산됩니다.깊은 이미지의 깊이 값은 계산된 각도의 사인과 코사인과 함께 사용되고 3D공간에서 각 포인트의 위치를 결정합니다. 거리 범위 필터링:지정된 대로 범위(`d_range`)에 속하지 않는 포인트는 필터링 됩니다.이는 깊이 값을 기반으로 마스크를 생성하고, 각 좌표 배열(x, y, z)에 적용하고 달성됩니다.3D포인트 클라우드 구성:유효한 x, y, z좌표는 새로운 축을 읽고 쌓아 최종 3D점 클라우드를 형성합니다.그 결과 각 요소가 3D공간의 포인트를 나타내는 배열이 생성됩니다.마지막으로 계산된 포인트의 클라우드는 이제 3차원 시각화 및 분석에 적합한 형식으로 되었습니다.포인트 클라우드 표현 시뮬레이션`animate_point_clouds`함수는 Open3D라이브러리를 사용하고 3D포인트 클라우드 시퀀스를 애니메이션화하도록 설계된 Python작업입니다.

def animate_point_clouds(point_clouds): vis = o3d.visualization.Visualizer() vis.create_window() # Set background color to black vis.get_render_option().background_color = np.array([0, 0, 0]) # Initialize point cloud geometry point_cloud = o3d.geometry.PointCloud() point_cloud.points = o3d.utility.Vector3dVector(point_clouds[0]) vis.add_geometry(point_cloud) frame_index = 0 last_update_time = time.time() update_interval = 0.25 # Time in seconds between frame updates while True: current_time = time.time()if current_time – last_update_time > update_interval: # Update point cloud with new data point_cloud.points = o3d.utility.Vector3dVector(point_clouds[frame_index]) vis.update_geometry(point_cloud) # Move to the next frame frame_index = (frame_index + 1) % len(point_clouds) last_update_time = current_time vis.poll_events() vis.update_renderer()if not vis.poll_events():break vis.destroy_window() def animate_point_clouds(point_clouds): vis = o3d.visualization.Visualizer() vis.create_window() # Set background color to black vis.get_render_option().background_color = np.array([0, 0, 0]) # Initialize point cloud geometry point_cloud = o3d.geometry.PointCloud() point_cloud.points = o3d.utility.Vector3dVector(point_clouds[0]) vis.add_geometry(point_cloud) frame_index = 0 last_update_time = time.time() update_interval = 0.25 # Time in seconds between frame updates while True: current_time = time.time()if current_time – last_update_time > update_interval: # Update point cloud with new data point_cloud.points = o3d.utility.Vector3dVector(point_clouds[frame_index]) vis.update_geometry(point_cloud) # Move to the next frame frame_index = (frame_index + 1) % len(point_clouds) last_update_time = current_time vis.poll_events() vis.update_renderer()if not vis.poll_events():break vis.destroy_window()

이 기능은 LiDAR스캔이나 시간에 의해서 바뀐 3D시뮬레이션 같은 동적 3D데이터를 시각화하는 데 특히 유용합니다.다음은 기능에 대한 자세한 분석입니다.시각화 설정:`animate_point_clouds`함수는 포인트 클라우드 데이터 리스트의 단일 인수`point_clouds`를 사용합니다.이 목록의 각 요소는 포인트 클라우드 애니메이션의 고유의 프레임을 나타냅니다.그 후 Open3D Visualizer객체(`vis`)을 초기화하고 포인트 클라우드의 애니메이션을 렌더링 하기 위한 새 창을 만듭니다.시각화 도구의 배경 색은 검은 색으로 설정(`np.array([0,0,0])`) 되어 포인트 클라우드 프레임의 가시성이 향상됩니다.3D포인트 클라우드 초기화: 새로운 Open3D PointCloud객체(`point_cloud`)가 생성됩니다.이 포인트 클라우드의 포인트는`point_clouds`리스트의 첫 프레임에 설정되어 초기 표시를 준비합니다.초기화된 포인트의 클라우드가 시각화 도구에 추가됩니다.시뮬레이션 루프:`frame_index`는 현재 표시되는 프레임을 추적하고,`last_update_time`는 프레임이 마지막으로 업데이트된 시간을 기록하고,`update_interval`는 프레임 업데이트 사이의 기간(초)을 설정하고,`while True`루프는 표시되는 포인트 클라우드를 지속적으로 업데이트해서`point_clouds`리스트의 프레임을 순환합니다.마지막 업데이트 이후 경과 시간이`update_interval`을 초과하는 경우에만 업데이트가 발생합니다.3D포인트 클라우드 업데이트:루프 내에서 포인트 클라우드 포인트가 현재 프레임의 데이터로 업데이트 되고, 지오 메트리가 시각화 도구에서 업데이트됩니다.이벤트 처리 및 렌더링:`vis.poll_events()`나`vis.update_renderer()`호출은 사용자 상호 작용을 처리하고 각각 시각화 도구의 렌더링을 업데이트합니다.시뮬레이션 종료:`vis.poll_events()`이 False를 반환하고 시각화 도구 창이 닫히는 경우 그룹이 중단되어 종료됩니다.마지막으로 시각화기의 창문은`vis.destroy_window()`에서 닫힙니다.시각화 실행이 마지막 코드 조각은 스크립트에서 이전에 정의한 함수를 사용하여 일련의 2D 깊은 이미지를 3D점 클라우드로 로드, 처리 및 시뮬레이션하기 위한 워크 플로를 제공합니다.이 기능은 LiDAR스캔이나 시간에 의해서 바뀐 3D시뮬레이션 같은 동적 3D데이터를 시각화하는 데 특히 유용합니다.다음은 기능에 대한 자세한 분석입니다.시각화 설정:`animate_point_clouds`함수는 포인트 클라우드 데이터 리스트의 단일 인수`point_clouds`를 사용합니다.이 목록의 각 요소는 포인트 클라우드 애니메이션의 고유의 프레임을 나타냅니다.그 후 Open3D Visualizer객체(`vis`)을 초기화하고 포인트 클라우드의 애니메이션을 렌더링 하기 위한 새 창을 만듭니다.시각화 도구의 배경 색은 검은 색으로 설정(`np.array([0,0,0])`) 되어 포인트 클라우드 프레임의 가시성이 향상됩니다.3D포인트 클라우드 초기화: 새로운 Open3D PointCloud객체(`point_cloud`)가 생성됩니다.이 포인트 클라우드의 포인트는`point_clouds`리스트의 첫 프레임에 설정되어 초기 표시를 준비합니다.초기화된 포인트의 클라우드가 시각화 도구에 추가됩니다.시뮬레이션 루프:`frame_index`는 현재 표시되는 프레임을 추적하고,`last_update_time`는 프레임이 마지막으로 업데이트된 시간을 기록하고,`update_interval`는 프레임 업데이트 사이의 기간(초)을 설정하고,`while True`루프는 표시되는 포인트 클라우드를 지속적으로 업데이트해서`point_clouds`리스트의 프레임을 순환합니다.마지막 업데이트 이후 경과 시간이`update_interval`을 초과하는 경우에만 업데이트가 발생합니다.3D포인트 클라우드 업데이트:루프 내에서 포인트 클라우드 포인트가 현재 프레임의 데이터로 업데이트 되고, 지오 메트리가 시각화 도구에서 업데이트됩니다.이벤트 처리 및 렌더링:`vis.poll_events()`나`vis.update_renderer()`호출은 사용자 상호 작용을 처리하고 각각 시각화 도구의 렌더링을 업데이트합니다.시뮬레이션 종료:`vis.poll_events()`이 False를 반환하고 시각화 도구 창이 닫히는 경우 그룹이 중단되어 종료됩니다.마지막으로 시각화기의 창문은`vis.destroy_window()`에서 닫힙니다.시각화 실행이 마지막 코드 조각은 스크립트에서 이전에 정의한 함수를 사용하여 일련의 2D 깊은 이미지를 3D점 클라우드로 로드, 처리 및 시뮬레이션하기 위한 워크 플로를 제공합니다.

# Directory containing the depth image filesdirectory = ‘archive/2011_09_30_drive_0028_sync/2011_09_30_drive_0028_sync/2011_09_30/2011_09_30_drive_0028_sync/velodyne_points/depth_images’# Load and process the framespoint_clouds = load_and_process_frames(directory)# Simulate the point cloudsanimate_point_clouds(point_clouds) # Directory containing the depth image filesdirectory = ‘archive/2011_09_30_drive_0028_sync/2011_09_30_drive_0028_sync/2011_09_30/2011_09_30_drive_0028_sync/velodyne_points/depth_images’# Load and process the framespoint_clouds = load_and_process_frames(directory)# Simulate the point cloudsanimate_point_clouds(point_clouds)

다음은 각 단계에 대한 자세한 설명입니다.디렉토리 경로 정의:변수`directory`에 깊은 이미지 파일이 들어 있는 폴더의 경로를 지정하는 문자열이 할당됩니다.이 경우 경로는 KITTI데이터 세트의 일반적인 중첩된 디렉토리 구조를 가리키고 특히 Velodyne LiDAR센서의 깊이의 이미지를 타겟팅합니다.프레임 로딩 및 처리:함수`load_and_process_frames`는 매수에`directory`변수를 사용하여 호출됩니다.그 후 함수는 지정된 디렉토리의 깊이의 이미지 파일을 반복해서 각 이미지를 로드하고 포인트 클라우드 표현으로 변환하고, 각 프레임의 결과 득점 클라우드를 리스트`point_clouds`으로 집계합니다.포인트 클라우드 시뮬레이션:함수`animate_point_clouds`은`point_clouds`명단에 호출됩니다.이는 포인트 클라우드 시퀀스를 시뮬레이션하고 캡처된 데이터의 동적 특성을 나타내는 시각화를 생성하도록 설계되었습니다.시뮬레이션은 Open3D시각화 도구로 만든 창에서 렌더링 되는 포인트 클라우드 시퀀스를 대화형으로 탐색할 수 있습니다.실험 결과 및 논의의 연구 기사의 이 섹션에서는 이 실험의 시각화의 결과를 살펴보겠습니다.다음은 각 단계에 대한 자세한 설명입니다.디렉토리 경로 정의:변수`directory`에 깊은 이미지 파일이 들어 있는 폴더의 경로를 지정하는 문자열이 할당됩니다.이 경우 경로는 KITTI데이터 세트의 일반적인 중첩된 디렉토리 구조를 가리키고 특히 Velodyne LiDAR센서의 깊이의 이미지를 타겟팅합니다.프레임 로딩 및 처리:함수`load_and_process_frames`는 매수에`directory`변수를 사용하여 호출됩니다.그 후 함수는 지정된 디렉토리의 깊이의 이미지 파일을 반복해서 각 이미지를 로드하고 포인트 클라우드 표현으로 변환하고, 각 프레임의 결과 득점 클라우드를 리스트`point_clouds`으로 집계합니다.포인트 클라우드 시뮬레이션:함수`animate_point_clouds`은`point_clouds`명단에 호출됩니다.이는 포인트 클라우드 시퀀스를 시뮬레이션하고 캡처된 데이터의 동적 특성을 나타내는 시각화를 생성하도록 설계되었습니다.시뮬레이션은 Open3D시각화 도구로 만든 창에서 렌더링 되는 포인트 클라우드 시퀀스를 대화형으로 탐색할 수 있습니다.실험 결과 및 논의의 연구 기사의 이 섹션에서는 이 실험의 시각화의 결과를 살펴보겠습니다.

図9: Street Velodyne 3D LiDAR POV – 시뮬레이션1 그림 9: Street Velodyne 3D LiDAR POV – 시뮬레이션1

図10: Street Velodyne 3D LiDAR POV – 시뮬레이션 2 그림 10: Street Velodyne 3D LiDAR POV – 시뮬레이션2

그림 11 : Street Velodyne 3D LiDAR 측면 보기 – 시뮬레이션 3 그림 11 : Street Velodyne 3D LiDAR 측면 보기 – 시뮬레이션 3

그림 12 : Street Velodyne 3D LiDAR 측면 보기 – 시뮬레이션4 그림 12: Street Velodyne 3D LiDAR 측면 보기 – 시뮬레이션4

FIGURE 13: Street Velodyne 3D LiDAR Top View – Simulation 5 FIGURE 13: Street Velodyne 3D LiDAR Top View – Simulation 5

그림 14:Street Velodyne 3D LiDAR의 상단을 보기 – 시뮬레이션 6을 이해하고 코드를 직접 사용하고 싶으면 여기에 코드를 보세요.3D LiDAR시각화의 다음 단계는 3D LiDAR객체 감지를 수행하는 기술을 살펴보는 것입니다.그러나 이 기사의 실험 결과를 더 분석하고 싶다면 계속 읽어 보세요.3D포인트 클라우드 표현 분석 출력 3D포인트 클라우드 시뮬레이션을 기반으로, 이는 3차원 LiDAR데이터를 시각화하는 일반적인 방법인 성향이 지정된 포인트의 클라우드입니다.위에 표시된 시뮬레이션에서 다양한 추론을 할 수 있습니다.색 그래 슈타디온 투:일반적으로 강도 또는 높이에 해당하며 포인트 클라우드 전체에 걸쳐서 변화를 보이고 줍니다.따뜻한 색( 붉은 색과 노란 색)는 센서의 시선에 수직인 더 높은 지점 또는 표면을 나타내는 반면 차가운 색(청색과 녹색)는 센서와 각도가 있는 더 낮은 영역 또는 표면을 나타냅니다.데이터 밀도:포인트의 밀도가 비교적 높은, 이 데이터를 캡처하는 데 사용된 3D LiDAR센서가 고해상도를 갖고 있음을 나타내며, 이것은 세밀한 분석에 필수입니다.센서 위치:이 시뮬레이션에서 포인트 클라우드의 관점은 LiDAR센서가 지면 수준 또는 차량에 위치하고 장면을 향하고 있음을 시사합니다.그러나 이 경우 센서는 차 위에 배치됐습니다.동적 범위:광범위한 색 범위는 캡처된 데이터에서 상당한 동적 범위를 의미하며 이는 다양한 유형의 표면과 객체를 구별하는데 도움이 될 수 있습니다.2D 깊은 프레임과 3D LiDAR비교 벌써 2D 깊은 지도와 3D포인트 클라우드 시뮬레이션을 비교하여 봅니다.여기에는 공간 데이터를 표현하는 방법의 근본적인 차이점을 이해하는 것이 포함됩니다.그림 14:Street Velodyne 3D LiDAR의 상단을 보기 – 시뮬레이션 6을 이해하고 코드를 직접 사용하고 싶으면 여기에 코드를 보세요.3D LiDAR시각화의 다음 단계는 3D LiDAR객체 감지를 수행하는 기술을 살펴보는 것입니다.그러나 이 기사의 실험 결과를 더 분석하고 싶다면 계속 읽어 보세요.3D포인트 클라우드 표현 분석 출력 3D포인트 클라우드 시뮬레이션을 기반으로, 이는 3차원 LiDAR데이터를 시각화하는 일반적인 방법인 성향이 지정된 포인트의 클라우드입니다.위에 표시된 시뮬레이션에서 다양한 추론을 할 수 있습니다.색 그래 슈타디온 투:일반적으로 강도 또는 높이에 해당하며 포인트 클라우드 전체에 걸쳐서 변화를 보이고 줍니다.따뜻한 색( 붉은 색과 노란 색)는 센서의 시선에 수직인 더 높은 지점 또는 표면을 나타내는 반면 차가운 색(청색과 녹색)는 센서와 각도가 있는 더 낮은 영역 또는 표면을 나타냅니다.데이터 밀도:포인트의 밀도가 비교적 높은, 이 데이터를 캡처하는 데 사용된 3D LiDAR센서가 고해상도를 갖고 있음을 나타내며, 이것은 세밀한 분석에 필수입니다.센서 위치:이 시뮬레이션에서 포인트 클라우드의 관점은 LiDAR센서가 지면 수준 또는 차량에 위치하고 장면을 향하고 있음을 시사합니다.그러나 이 경우 센서는 차 위에 배치됐습니다.동적 범위:광범위한 색 범위는 캡처된 데이터에서 상당한 동적 범위를 의미하며 이는 다양한 유형의 표면과 객체를 구별하는데 도움이 될 수 있습니다.2D 깊은 프레임과 3D LiDAR비교 벌써 2D 깊은 지도와 3D포인트 클라우드 시뮬레이션을 비교하여 봅니다.여기에는 공간 데이터를 표현하는 방법의 근본적인 차이점을 이해하는 것이 포함됩니다.

그림 15 : 입력 2D 깊이 맵 대 3D 포인트 클라우드 시뮬레이션 비교 그림 15 : 입력 2D 깊이 맵 대 3D 포인트 클라우드 시뮬레이션 비교

2D의 깊이 맵은 본질적으로 각 픽셀의 값이 센서에서 직선 시야를 의해서 가장 가까운 표면 지점까지의 거리를 나타내는 2차원 이미지입니다.깊이 맵은 다양한 음영이 다양한 거리에 해당되는 후에섹쵸이메ー지과 유사합니다.일반적으로 3D포인트 클라우드에 비해서 처리하는 데 필요한 컴퓨팅 파워가 적습니다.표준 이미지 처리 기술이나 알고리즘과 더 호환됩니다.귀중한 거리 정보를 제공하지만 장면에서 오브젝트의 공간적인 배열 및 관계에 대한 맥락을 잃을 수 있습니다.한편 3D점 클라우드는 3차원 좌표계의 포인트 모음의 포인트 클라우드입니다.포인트 클라우드의 각 포인트는 객체의 표면의 작은 부분을 나타내므로 장면을 보다 전체적으로 공간적으로 정확히 표현합니다.포인트 클라우드를 처리하기 위해서는 종종 더 많은 컴퓨팅 자원이 필요합니다.분할, 객체 인식 및 3D재구성과 같은 작업에 대한 특수 알고리즘이 필요합니다.또 공간과 객체 지오 메트리를 보다 상세하고 정확히 표현하는 고충실도의 공간 데이터가 필요한 작업에 더 적합합니다.자율 주행을 위한 3D LiDAR에서 얻은 통찰력이 하위 섹션에서는 3D점 클라우드를 분석하고 2D 깊은 프레임과 비교해서 얻은 통찰력을 찾아 보겠습니다.이는 자율 주행 애플리케이션에 중요한 의미를 지닙니다.향상된 환경 인식:3D포인트 클라우드의 색 그래 슈타디온 투로 높은 데이터 밀도는 환경에 대한 상세하고 미묘한 인식을 제공합니다.자율 주행에서 이런 수준의 상세는 복잡한 도시 경관 도로 상태 및 잠재적 장애물을 정확히 식별하고 탐색하는데 중요합니다.개선된 장애물 감지 및 분류:3D점 클라우드가 객체의 지오 메트리와 표면의 특성을 묘사할 수 있는 기능을 통해서 보다 효과적인 장애물 감지 및 분류가 가능합니다.이는 자율 주행 차량의 의사 결정 프로세스, 특히 정적 객체(예:가로등)와 동적 객체(예:보행자)를 구별하는 데 필수적입니다.깊이 지각과 공간 인식:2D 깊은 맵과 달리 3D점 클라우드는 뛰어난 깊이 지각과 공간 인식을 제공합니다.이는 자율 주행 차량이 주변 환경을 3차원에서 이해하기에 중요하고 안전한 내비게이션, 기동에 필수입니다.센서 융합 및 데이터 통합:이 비교는 또한 다양한 셍사ー모달리티을 통합하는 것의 중요성을 강조합니다.3D LiDAR센서의 고해상도의 공간 데이터와 카메라의 색과 질감 정보를 결합하면 차량 주변 환경을 보다 포괄적으로 이해할 수 있습니다.경로 계획 및 내비게이션:3D포인트 클라우드의 자세한 정보는 보다 정확한 경로 계획 및 내비게이션에 도움이 됩니다.환경의 지형과 레이아웃을 이해하면 더 효율적이고 안전한 경로 계획이 보장됩니다.향후 작업 및 개선 사항 특히 자율 주행 애플리케이션을 위한 3D포인트 클라우드 데이터의 맥락에서 시각화 기술의 잠재적인 개선은 명확성, 정확성 및 사용자 상호 작용을 향상시키는 것을 목표로 하는 광범위한 발전을 포함합니다.이 가운데 핵심은 실시간 처리 능력의 향상에 자율 주행 자동차로 신속한 의사 결정에 중요한 데이터를 더 빠르고 효율적으로 해석할 수 있습니다.인공 지능과 기계 학습 알고리즘을 통합하면 더 스마트한 시각화가 가능하며 자동 기능 감지, 이상의 식별 및 예측 분석이 쉽게 됩니다.포인트 클라우드의 해상도를 높이면 정밀한 객체의 감지 및 장면의 해석에 중요한 더 미세한 환경의 상세 정보를 캡처할 수 있습니다.색 매핑 및 테크 스쵸링 기술의 발전은 특히 LiDAR데이터를 카메라의 이미지와 통합하고 풍부한 텍스처의 3D모델을 만들 때보다 사실적이고 유익한 시각화를 제공할 수 있습니다.대화형의 시각화 툴을 개발하면 사용자가 3D포인트 클라우드 데이터를 보다 직관적으로 탐색하고 분석할 수 있고, 전문 지식이 없는 사용자의 사용성이 향상합니다.증강 현실 및 가상 현실 기술을 통합하면, 몰입형 3D환경을 제공하고 복잡한 데이터 세트에 대한 의한 직관적인 이해를 제공할 수 있습니다.이 밖에도 고급 노이즈 감소 및 데이터 필터링 기술을 구현하는 것은 시각화의 선명도를 높이고 복잡한 장면을 정확하게 해석하는데 필수적입니다.확장성 및 대용량 데이터 관리를 해결하면 성능 저하 없이 광범위한 데이터 세트를 처리할 수 있고, 이는 광대한 지역이나 확장된 시간 프레임을 분석하는 데 필수입니다.조정 가능한 관점 및 렌더링 스타일을 포함하고 다양한 사용자 요구 사항과 호감도에 맞는 사용자 지정 시각화 옵션은 이런 도구의 유용성과 접근성을 향상시킵니다.마지막으로 이런 시각화 도구가 모바일 기기를 포함한 다양한 플랫폼에 접속할 수 있는 광범위한 사용자 기반으로 사용하기 쉽게 보장하면 적용 가능성과 영향이 크게 확대됩니다.결론이 연구 논문은 자율 주행의 맥락에서 3D포인트 클라우드 데이터 시각화와 2D 깊은 프레임과 비교를 주의 깊게 탐구했습니다.이 연구의 주요 결과는 자율 주행 차량의 환경을 정확히 매핑으로 해석하는 데 가장 중요한 세부적이고 고해상도의 공간 데이터를 제공하는 3D LiDAR센서의 심오한 역량을 강조합니다.2D 깊은 이미지는 계산 집약도가 낮지만 특히 복잡한 도시 환경에서 3D점 클라우드가 제공하는 완전한 공간적 상황을 파악하는데 가끔 부족합니다.이런 결과가 자율 주행 분야에 미치는 영향은 상당합니다.3D점 클라우드가 제공하는 향상된 인식과 향상된 장애물 감지 및 분류 기능은 자율 주행 차의 안전성, 신뢰성과 효율성을 향상시키는 데 매우 중요합니다.참고 문헌[1]Xin Wang et al 2020 IOP Conf.Ser.:Earth Environ.Sci.502 012008.https://iopscience.iop.org/article/10.1088/1755-1315/502/1/012008/pdf[2]Tu, X.;Xu, C.;Liu, S.;Lin, S.;Chen, L.;Xie, G.;Li, R. 오버 헤드 접촉 검사를 위한 디프 달리기를 통한 LiDAR포인트 클라우드 인식 및 시각화. 센서 2020,20,6387.https://doi.org/10.3390/s20216387[3]2D의 깊이 맵은 본질적으로 각 픽셀의 값이 센서에서 직선 시야를 의해서 가장 가까운 표면 지점까지의 거리를 나타내는 2차원 이미지입니다.깊이 맵은 다양한 음영이 다양한 거리에 해당되는 후에섹쵸이메ー지과 유사합니다.일반적으로 3D포인트 클라우드에 비해서 처리하는 데 필요한 컴퓨팅 파워가 적습니다.표준 이미지 처리 기술이나 알고리즘과 더 호환됩니다.귀중한 거리 정보를 제공하지만 장면에서 오브젝트의 공간적인 배열 및 관계에 대한 맥락을 잃을 수 있습니다.한편 3D점 클라우드는 3차원 좌표계의 포인트 모음의 포인트 클라우드입니다.포인트 클라우드의 각 포인트는 객체의 표면의 작은 부분을 나타내므로 장면을 보다 전체적으로 공간적으로 정확히 표현합니다.포인트 클라우드를 처리하기 위해서는 종종 더 많은 컴퓨팅 자원이 필요합니다.분할, 객체 인식 및 3D재구성의 같은